Google despliega nuevas funciones de Gemini Live

Google ha comenzado a desplegar nuevas funciones de Inteligencia Artificial en su asistente Gemini Live, que permiten interactuar con el entorno en tiempo real mediante el análisis de vídeo en directo captado por la cámara del dispositivo móvil y la posibilidad de compartir la pantalla del teléfono. Estas mejoras, disponibles inicialmente para dispositivos Android, suponen un nuevo paso en el desarrollo de asistentes digitales inteligentes que responden a las acciones y el contexto del usuario.

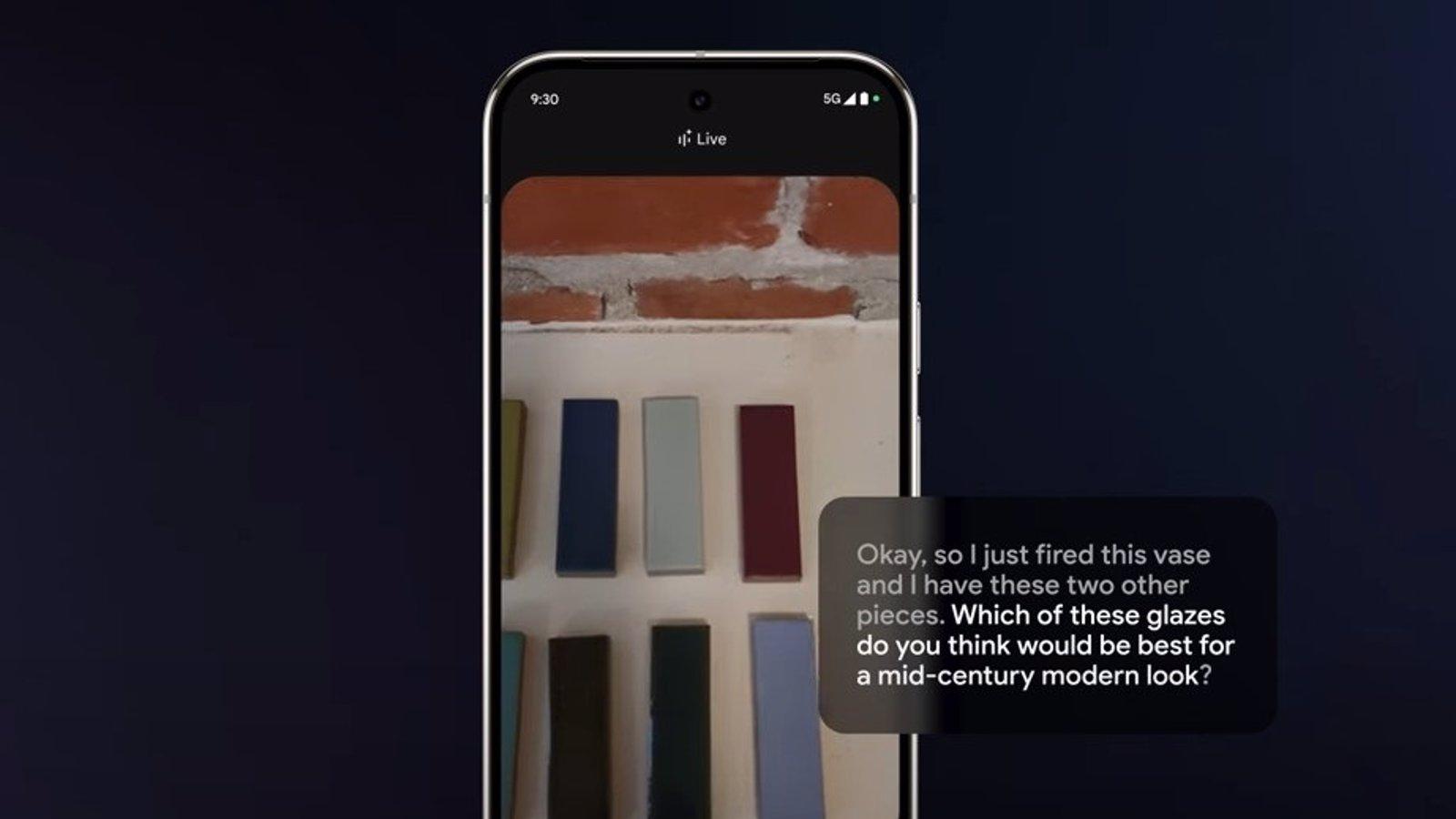

Entre las novedades destacadas, Gemini Live ahora permite a los usuarios utilizar la cámara de su smartphone para mostrar elementos del entorno al asistente de voz, que analizará en tiempo real las imágenes y ofrecerá respuestas relacionadas con lo que aparece en pantalla. Esta funcionalidad permite, por ejemplo, obtener información sobre objetos, resolver dudas sobre productos o identificar elementos visuales simplemente apuntando con la cámara.

Junto a esta capacidad visual, se ha activado también la opción de compartir la pantalla del dispositivo con Gemini Live, permitiendo al asistente leer y comprender el contenido mostrado para ofrecer respuestas contextuales más precisas. Desde la interfaz de una aplicación hasta una página web o una imagen, Gemini puede interpretar lo que el usuario está viendo para proporcionar asistencia ajustada al contenido.

Estas funcionalidades se enmarcan en el proyecto Astra de Google, anunciado durante la conferencia Google I/O 2024. Astra busca consolidar una nueva generación de asistentes de inteligencia artificial capaces de interactuar con el entorno físico y digital del usuario, proporcionando respuestas basadas no solo en el lenguaje escrito o hablado, sino también en lo que el usuario está haciendo o viendo.

Las nuevas capacidades de Gemini Live están siendo desplegadas en los dispositivos Android dentro del plan Google One AI Premium, exclusivo para suscriptores de Gemini Advanced. Según confirmó el portavoz de la compañía, Alex Joseph, en declaraciones al medio especializado The Verge, estas herramientas ya han comenzado a estar disponibles para algunos usuarios, tal y como se ha detectado en foros como Reddit.

Con esta actualización, Google apuesta por una IA más presente y proactiva en la vida diaria del usuario, capaz de integrarse en los gestos cotidianos y ofrecer respuestas no solo a preguntas verbales, sino también a partir de imágenes y acciones en curso. La compañía sigue así la estela marcada por el auge de asistentes contextuales, con una visión más cercana al usuario y al entorno que le rodea.